本文介绍PyTorch模型转换为ONNX的入门教程,助力手游开发者优化游戏AI性能。

在手游开发领域,AI技术的运用日益广泛,从智能NPC的行为模拟到游戏内数据分析,都离不开高效的机器学习模型,不同框架间的模型兼容性一直是开发者面临的难题,PyTorch作为当前最受欢迎的深度学习框架之一,以其灵活性和易用性赢得了众多手游开发者的青睐,当需要将训练好的PyTorch模型部署到生产环境,特别是跨平台、跨设备时,ONNX(Open Neural Network Exchange)格式便显得尤为重要,本文将详细介绍如何将PyTorch模型转换为ONNX格式,从而加速游戏AI的部署与优化。

中心句:ONNX格式简介及其在游戏开发中的应用优势。

ONNX是一个开放格式,用于表示深度学习模型,它使得模型可以在不同的框架、工具、运行时和硬件之间轻松迁移,对于手游开发者而言,这意味着可以将训练好的PyTorch模型转换为ONNX格式,然后利用ONNX Runtime或其他兼容的推理引擎,在多种设备上实现高效推理,这不仅提高了模型的兼容性,还降低了部署成本,同时保证了游戏AI的性能表现,特别是在资源受限的移动设备上,ONNX格式能够显著提升模型的推理速度,减少延迟,提升用户体验。

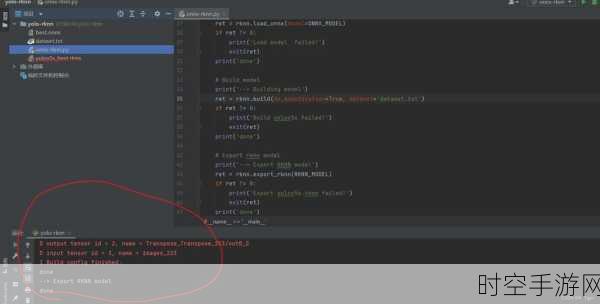

中心句:PyTorch模型转换为ONNX的详细步骤。

我们将通过具体步骤,展示如何将PyTorch模型转换为ONNX格式,确保你的环境中已经安装了PyTorch和ONNX库,加载你训练好的PyTorch模型,并准备好输入数据(这里以一个简单的神经网络为例),使用torch.onnx.export函数将模型导出为ONNX格式,这个函数需要指定模型、输入数据、输出文件名以及一系列可选参数,如opset_version(操作集版本),它决定了ONNX模型支持的特性和操作,完成这些步骤后,你将得到一个.onnx文件,这就是你的模型在ONNX格式下的表示。

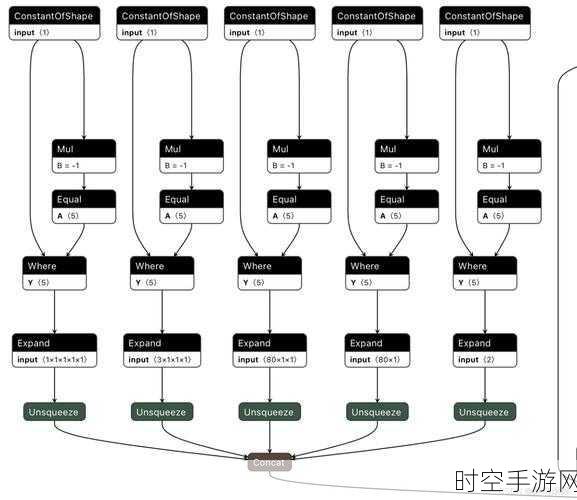

中心句:优化ONNX模型以适应手游环境。

得到ONNX模型后,还需要进行一系列优化,以确保其在手游环境中的高效运行,这包括量化(Quantization)和剪枝(Pruning)等技术,它们能够减少模型的体积和计算量,从而提高推理速度,还可以利用ONNX Runtime的优化功能,如图形优化、内存优化和线程优化等,进一步提升模型的性能,这些优化步骤对于资源受限的移动设备尤为重要,它们能够确保游戏AI在保持高精度的同时,实现低延迟、高流畅度的用户体验。

中心句:实际案例分享与未来展望。

为了更直观地展示PyTorch到ONNX模型转换的应用效果,我们分享了一个实际案例:某知名手游开发者利用这一技术,成功将游戏中的智能NPC行为模拟模型从PyTorch迁移到ONNX格式,并在多个平台上实现了高效推理,这一转变不仅提升了游戏的AI性能,还显著降低了部署成本和维护难度,随着ONNX格式的不断发展和完善,以及更多支持ONNX的推理引擎的出现,手游开发者将能够更加便捷地将先进的机器学习技术应用于游戏开发中,推动游戏AI的进一步发展。

参考来源:本文基于PyTorch官方文档和ONNX官方指南整理而成。

通过本文的介绍,相信手游开发者们已经对PyTorch模型转换为ONNX格式有了更深入的了解,掌握这一技术,将为你的游戏AI部署带来前所未有的便利和性能提升,让我们携手共进,探索游戏AI的无限可能!